Novos modelos e produtos para desenvolvedores anunciados no DevDay

No último dia 6 de novembro, compartilhamos dezenas de novas adições e melhorias e reduzimos preços em muitas partes da nossa plataforma. Esses incluem:

- Novo modelo GPT-4 Turbo que é mais capaz, mais barato e suporta uma janela de contexto de 128K

- Nova API Assistants que torna mais fácil para os desenvolvedores criarem seus próprios aplicativos assistivos de IA que têm objetivos e podem chamar modelos e ferramentas

- Novas capacidades multimodais na plataforma, incluindo visão, criação de imagens (DALL·E 3) e conversão de texto em fala (TTS)

Começaremos a lançar novos recursos para clientes OpenAI a partir das 13h (horário do Pacífico) de hoje.

Saiba mais sobre os anúncios do OpenAI DevDay para ChatGPT .

GPT-4 Turbo com contexto de 128K

Lançamos a primeira versão do GPT-4 em março e disponibilizamos o GPT-4 para todos os desenvolvedores em julho. Hoje estamos lançando uma prévia da próxima geração deste modelo, o GPT-4 Turbo .

O GPT-4 Turbo é mais capaz e tem conhecimento de eventos mundiais até abril de 2023. Possui uma janela de contexto de 128k para caber o equivalente a mais de 300 páginas de texto em um único prompt. Também otimizamos seu desempenho para que possamos oferecer o GPT-4 Turbo a um preço 3x mais barato para tokens de entrada e um preço 2x mais barato para tokens de saída em comparação com o GPT-4.

O GPT-4 Turbo está disponível para todos os desenvolvedores pagantes experimentarem passando gpt-4-1106-previewa API e planejamos lançar o modelo estável pronto para produção nas próximas semanas.

Atualizações de chamada de função

A chamada de função permite descrever funções do seu aplicativo ou APIs externas para modelos e fazer com que o modelo escolha de forma inteligente gerar um objeto JSON contendo argumentos para chamar essas funções. Estamos lançando diversas melhorias hoje, incluindo a capacidade de chamar múltiplas funções em uma única mensagem: os usuários podem enviar uma mensagem solicitando múltiplas ações, como “abrir a janela do carro e desligar o A/C”, o que anteriormente exigiria múltiplas ida e volta com o modelo ( saiba mais ). Também estamos melhorando a precisão da chamada de função: é mais provável que o GPT-4 Turbo retorne os parâmetros de função corretos.

Seguimento de instruções aprimorado e modo JSON

O GPT-4 Turbo tem um desempenho melhor que nossos modelos anteriores em tarefas que exigem o seguimento cuidadoso de instruções, como a geração de formatos específicos (por exemplo, “responder sempre em XML”). Ele também oferece suporte ao nosso novo modo JSON , que garante que o modelo responderá com JSON válido. O novo parâmetro da API response_formatpermite que o modelo restrinja sua saída para gerar um objeto JSON sintaticamente correto. O modo JSON é útil para desenvolvedores que geram JSON na API Chat Completions fora da chamada de função.

Saídas reproduzíveis e probabilidades de log

O novo seedparâmetro permite resultados reproduzíveis , fazendo com que o modelo retorne conclusões consistentes na maioria das vezes. Esse recurso beta é útil para casos de uso como reprodução de solicitações de depuração, gravação de testes de unidade mais abrangentes e, geralmente, maior grau de controle sobre o comportamento do modelo. Nós da OpenAI temos usado esse recurso internamente para nossos próprios testes de unidade e o consideramos inestimável. Estamos entusiasmados para ver como os desenvolvedores irão usá-lo. Saiba mais .

Também estamos lançando um recurso para retornar as probabilidades de log para os tokens de saída mais prováveis gerados pelo GPT-4 Turbo e GPT-3.5 Turbo nas próximas semanas, o que será útil para criar recursos como o preenchimento automático em uma experiência de pesquisa.

Turbo GPT-3.5 atualizado

Além do GPT-4 Turbo, também estamos lançando uma nova versão do GPT-3.5 Turbo que suporta uma janela de contexto de 16K por padrão. O novo 3.5 Turbo suporta instrução aprimorada, modo JSON e chamada de função paralela. Por exemplo, nossas avaliações internas mostram uma melhoria de 38% nas tarefas de seguimento de formato, como geração de JSON, XML e YAML. Os desenvolvedores podem acessar esse novo modelo chamando gpt-3.5-turbo-1106a API. Os aplicativos que usam o gpt-3.5-turbonome serão atualizados automaticamente para o novo modelo em 11 de dezembro. Os modelos mais antigos continuarão acessíveis por meio gpt-3.5-turbo-0613da API até 13 de junho de 2024. Saiba mais .

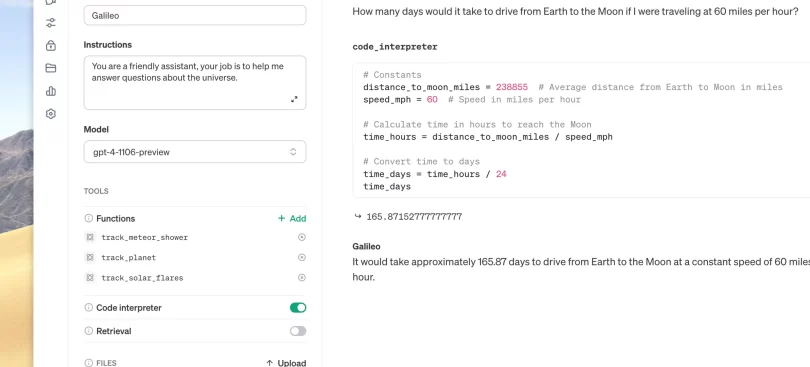

API de assistentes, recuperação e intérprete de código

Hoje estamos lançando a API Assistants , nosso primeiro passo para ajudar os desenvolvedores a criar experiências semelhantes às dos agentes em seus próprios aplicativos. Um assistente é uma IA desenvolvida especificamente que possui instruções específicas, aproveita conhecimento extra e pode chamar modelos e ferramentas para executar tarefas. A nova API de assistentes fornece novos recursos, como intérprete e recuperação de código, bem como chamadas de função para lidar com grande parte do trabalho pesado que você mesmo tinha que fazer anteriormente e permitir a criação de aplicativos de IA de alta qualidade.

Esta API foi projetada para oferecer flexibilidade; os casos de uso variam de um aplicativo de análise de dados baseado em linguagem natural, um assistente de codificação, um planejador de férias com tecnologia de IA, um DJ controlado por voz, uma tela visual inteligente – a lista continua. A API Assistants é baseada nos mesmos recursos que habilitam nosso novo produto GPTs : instruções e ferramentas personalizadas, como intérprete de código, recuperação e chamada de função.

Uma mudança importante introduzida por esta API são os threads persistentes e infinitamente longos , que permitem aos desenvolvedores transferir o gerenciamento do estado do thread para o OpenAI e contornar as restrições da janela de contexto. Com a API Assistants, basta adicionar cada nova mensagem a um arquivo thread.

Os assistentes também têm acesso para chamar novas ferramentas conforme necessário, incluindo:

- Intérprete de código : escreve e executa código Python em um ambiente de execução em sandbox, podendo gerar gráficos e tabelas e processar arquivos com dados e formatações diversos. Ele permite que seus assistentes executem código iterativamente para resolver problemas desafiadores de código e matemática e muito mais.

- Recuperação : amplia o assistente com conhecimento externo aos nossos modelos, como dados de domínio proprietário, informações de produtos ou documentos fornecidos por seus usuários. Isso significa que você não precisa calcular e armazenar embeddings para seus documentos ou implementar algoritmos de segmentação e pesquisa. A API Assistants otimiza qual técnica de recuperação usar com base em nossa experiência na construção de recuperação de conhecimento no ChatGPT.

- Chamada de função : permite que os assistentes invoquem funções definidas por você e incorporem a resposta da função em suas mensagens.

Tal como acontece com o resto da plataforma, os dados e arquivos passados para a API OpenAI nunca são usados para treinar nossos modelos e os desenvolvedores podem excluir os dados quando acharem adequado.

Você pode experimentar a versão beta da API Assistants sem escrever nenhum código acessando o playground do Assistants .

Use o playground de Assistentes para criar assistentes de alta qualidade sem código.

A API Assistants está em versão beta e disponível para todos os desenvolvedores a partir de hoje. Compartilhe o que você construiu conosco ( @OpenAI ) junto com seus comentários, que incorporaremos à medida que continuarmos construindo nas próximas semanas. Os preços das APIs Assistants e suas ferramentas estão disponíveis em nossa página de preços .

Novas modalidades na API

GPT-4 Turbo com visão

GPT-4 Turbo pode aceitar imagens como entradas na API Chat Completions, permitindo casos de uso como geração de legendas, análise detalhada de imagens do mundo real e leitura de documentos com figuras. Por exemplo, BeMyEyes usa essa tecnologia para ajudar pessoas cegas ou com baixa visão em tarefas diárias, como identificar um produto ou navegar em uma loja. Os desenvolvedores podem acessar esse recurso usando gpt-4-vision-previewa API. Planejamos implementar suporte de visão para o modelo principal do GPT-4 Turbo como parte de seu lançamento estável. O preço depende do tamanho da imagem de entrada. Por exemplo, passar uma imagem com 1080×1080 pixels para GPT-4 Turbo custa US$ 0,00765. Confira nosso guia de visão .

DE E 3

Os desenvolvedores podem integrar o DALL·E 3, que lançamos recentemente para usuários do ChatGPT Plus e Enterprise, diretamente em seus aplicativos e produtos por meio de nossa API de imagens, especificando dall-e-3como modelo. Empresas como Snap, Coca-Cola e Shutterstock usaram o DALL·E 3 para gerar imagens e designs de forma programática para seus clientes e campanhas. Semelhante à versão anterior do DALL·E, a API incorpora moderação integrada para ajudar os desenvolvedores a proteger seus aplicativos contra uso indevido. Oferecemos diversas opções de formato e qualidade, com preços a partir de US$ 0,04 por imagem gerada. Confira nosso guia para começar a usar o DALL·E 3 na API.

Conversão de texto para fala (TTS)

Os desenvolvedores agora podem gerar fala com qualidade humana a partir de texto por meio da API de conversão de texto em fala. Nosso novo modelo TTS oferece seis vozes predefinidas para escolher e duas variantes de modelo, tts-1e tts-1-hd. ttsé otimizado para casos de uso em tempo real e tts-1-hdotimizado para qualidade. O preço começa em US$ 0,015 por entrada de 1.000 caracteres. Confira nosso guia TTS para começar.

Ouça amostras de voz

Selecionar textoCênicoinstruçõesTécnicoReceita

À medida que o sol dourado mergulha no horizonte, lançando longas sombras sobre a campina tranquila, o mundo parece silenciar e uma sensação de calma envolve a Terra, prometendo uma noite de descanso tranquila para todos os seres vivos.

Selecione a vozLigaEcoFábulaÔnixNovaBrilho

Personalização do modelo

Acesso experimental de ajuste fino GPT-4

Estamos criando um programa de acesso experimental para ajuste fino do GPT-4 . Os resultados preliminares indicam que o ajuste fino do GPT-4 requer mais trabalho para alcançar melhorias significativas em relação ao modelo básico em comparação com os ganhos substanciais obtidos com o ajuste fino do GPT-3.5. À medida que a qualidade e a segurança do ajuste fino do GPT-4 melhoram, os desenvolvedores que usam ativamente o ajuste fino do GPT-3.5 terão a opção de aplicar ao programa GPT-4 em seu console de ajuste fino .

Modelos personalizados

Para organizações que precisam de ainda mais personalização do que o ajuste fino pode oferecer (particularmente aplicável a domínios com conjuntos de dados proprietários extremamente grandes – bilhões de tokens no mínimo), também estamos lançando um programa de Modelos Personalizados, dando às organizações selecionadas a oportunidade de trabalhar com um grupo dedicado de pesquisadores OpenAI para treinar GPT-4 personalizado para seu domínio específico. Isso inclui a modificação de cada etapa do processo de treinamento do modelo, desde a realização de pré-treinamento adicional específico do domínio até a execução de um processo de pós-treinamento de RL personalizado, adaptado para o domínio específico. As organizações terão acesso exclusivo aos seus modelos personalizados. De acordo com nossas políticas de privacidade empresarial existentes, modelos personalizados não serão fornecidos ou compartilhados com outros clientes nem usados para treinar outros modelos. Além disso, os dados proprietários fornecidos à OpenAI para treinar modelos personalizados não serão reutilizados em nenhum outro contexto. Este será um programa muito limitado (e caro) para começar – as organizações interessadas podem se inscrever aqui .

Preços mais baixos e limites de taxas mais altos

Preços mais baixos

Estamos diminuindo vários preços em toda a plataforma para repassar as economias aos desenvolvedores (todos os preços abaixo são expressos por 1.000 tokens):

- Os tokens de entrada GPT-4 Turbo são 3x mais baratos que o GPT-4, custando US$ 0,01, e os tokens de saída são 2x mais baratos, custando US$ 0,03.

- Os tokens de entrada GPT-3.5 Turbo são 3x mais baratos que o modelo anterior de 16K, custando US$ 0,001, e os tokens de saída são 2x mais baratos, custando US$ 0,002. Os desenvolvedores que anteriormente usavam GPT-3.5 Turbo 4K se beneficiam de uma redução de 33% nos tokens de entrada a US$ 0,001. Esses preços mais baixos se aplicam apenas ao novo GPT-3.5 Turbo lançado hoje.

- Os tokens de entrada do modelo GPT-3.5 Turbo 4K ajustados são reduzidos em 4x, a US$ 0,003, e os tokens de saída são 2,7x mais baratos, a US$ 0,006. O ajuste fino também suporta contexto de 16K pelo mesmo preço de 4K com o novo modelo GPT-3.5 Turbo. Esses novos preços também se aplicam a modelos ajustados

gpt-3.5-turbo-0613.

| Modelos mais antigos | Novos modelos | |

| Turbo GPT-4 | Entrada GPT-4 8K : $ 0,03 Saída: $ 0,06 Entrada GPT-4 32K : $ 0,06 Saída: $ 0,12 | Entrada GPT-4 Turbo 128K : $ 0,01 Saída: $ 0,03 |

| Turbo GPT-3.5 | Entrada GPT-3.5 Turbo 4K : $ 0,0015 Saída: $ 0,002 Entrada GPT-3.5 Turbo 16K : $ 0,003 Saída: $ 0,004 | Entrada GPT-3.5 Turbo 16K : $ 0,001 Saída: $ 0,002 |

| Ajuste fino do GPT-3.5 Turbo | Treinamento de ajuste fino do GPT-3.5 Turbo 4K : $ 0,008 Entrada: $ 0,012 Saída: $ 0,016 | Treinamento de ajuste fino GPT-3.5 Turbo 4K e 16K : $ 0,008 Entrada: $ 0,003 Saída: $ 0,006 |

Limites de taxa mais altos

Para ajudá-lo a dimensionar seus aplicativos, estamos dobrando o limite de tokens por minuto para todos os nossos clientes pagantes do GPT-4. Você pode visualizar seus novos limites de taxas na página de limites de taxas . Também publicamos nossos níveis de uso que determinam aumentos automáticos dos limites de taxa, para que você saiba o que esperar sobre como seus limites de uso serão escalonados automaticamente. Agora você pode solicitar aumentos nos limites de uso nas configurações da sua conta .

Escudo de Direitos Autorais

A OpenAI está comprometida em proteger nossos clientes com proteções de direitos autorais integradas em nossos sistemas. Hoje, estamos dando um passo adiante e introduzindo o Copyright Shield. Agora interviremos e defenderemos nossos clientes e pagaremos os custos incorridos caso você enfrente ações judiciais relacionadas a violação de direitos autorais. Isso se aplica aos recursos geralmente disponíveis do ChatGPT Enterprise e de nossa plataforma de desenvolvedor.

Whisper v3 e decodificador de consistência

Estamos lançando o Whisper large-v3, a próxima versão do nosso modelo de reconhecimento automático de fala (ASR) de código aberto que apresenta desempenho aprimorado em vários idiomas. Também planejamos oferecer suporte ao Whisper v3 em nossa API em um futuro próximo.

Também estamos abrindo o código do Consistency Decoder , um substituto para o decodificador Stable Diffusion VAE. Este decodificador melhora todas as imagens compatíveis com o Stable Diffusion 1.0+ VAE, com melhorias significativas em texto, faces e linhas retas.

Saiba mais sobre nossos anúncios OpenAI DevDay para ChatGPT .

Fonte: OpenAI